AI Cavern

Введение

Данный проект исследует, как генеративные нейросети могут быть интегрированы в процесс создания CGI сцены с VFX, чтобы проверить, насколько ИИ способен в компьютерной графике.

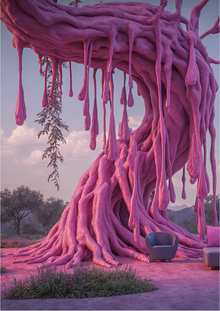

Генерация концепта

Концепт-арт работы был сгенерирован при помощи ИИ по итеративному принципу. Сначала были сформированы общие очертания и настроение сцены, а затем в процессе добавлялись детали и новые элементы. Для формулирования четкого и понятного для языковой модели промпта я использовал Chat GPT, а для его визуализации — DALL·E, генератору изображений внутри Chat GPT.

Промпт:

Generate a wide cavern environment with rough rock formations and large silhouettes. Define main walls, arches, and stalagmites to establish composition and scale. Keep atmosphere minimal but slightly foggy for depth. No detailed textures, focus on broad shapes and lighting balance.

Промпт:

Iterate on the base cavern. Add medium-scale details to stalagmites and walls, introduce soft cold lighting for volume and mood, preserve composition and scale. Keep forms readable, avoid overdetailing.

Промпт:

Add dynamic waterfalls descending from the cavern ceiling, illuminating the scene with cool reflected light. Maintain the natural lighting and vast sense of scale. Introduce light mist and reflections on the wet surfaces to enhance atmosphere. Keep composition spacious and uncluttered, focusing on vertical flow and luminous depth.

Генерация ассетов

Для финализации концепта и разборки на ассеты использовались две новые нейросети — Gigapixel AI, а также Adobe Firefly.

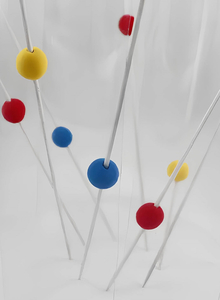

После того, как водопады были изолированы при помощи Firefly, для них в DALL·E были созданы маски и текстуры для VFX. Каждая из текстур разделена по каналам RGBA, где каждый цвет отвечает за свой слой данных.

Для водоема были созданы кастомные UV, сгенерированные для создания волн с учетом формы или «течения». Также генеративным заполнением была расширена текстура воды с учетом возможного клиппинга и создана альфа маска.

Для окружения в том числе были сгенерированы специальные текстуры — Depth Map и Normal Map, для создания которых использовались ИИ инструменты в Adobe Camera Raw и 3D Sampler соответственно.

Сборка и VFX

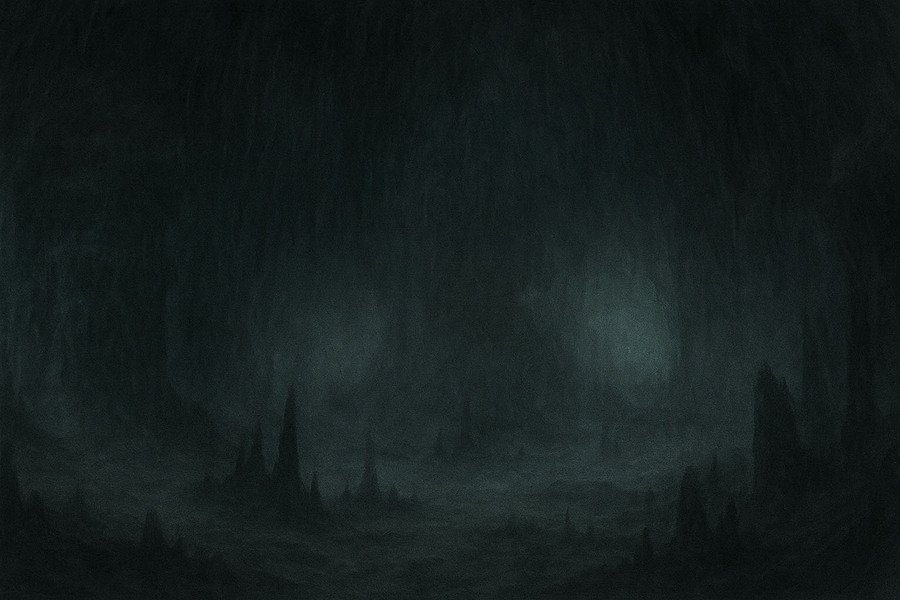

Как я уже говорил, ассеты объединялись послойно — именно поэтому нужны были Alpha маски и Depth map. В качестве софта сборки сцены и рендера был выбран Blender.

Уже выглядит довольно приближенно к концепту, но все еще недостаточно хорошо само по себе. Поэтому в игру вступают VFX. Немного небольших текстур для партиклов, каустики и прочих эффектов, и сцена оживет.

Немного шейдерной математики и изображение оживает.

Поскольку это все ещё 2D сцена, текстуры играют роль и в пост процессе. Например, Depth Map определяет силу Defocus эффекта, а также использована для наложения партиклов поверх сцены.

Итог

Этот эксперимент показал, что нейросети в целом способны следовать указаниям и создавать стилизованные VFX-текстуры, опираясь на заранее подготовленный материал. Однако им по-прежнему присущи огрехи: модели иногда игнорируют отдельные инструкции или теряют оригинальную форму и текстуру. В итоге ИИ остаётся не заменой человеку, а инструментом, требующим человеческого контроля и доработки.

Использованные AI инструменты:

1. Chat GPT & DALL·E 2. Adobe Firefly & Camera Raw 3. Topaz Gigapixel AI