Обучение генеративной сети эстетике обложек рэп-альбомов 90-х

Рэп-культура 90-х оставила после себя уникальный визуальный язык, настолько специфичный, что он так и не вышел из андерграунда и его влияние практически не ощущается в других областях визуальных искусств.

Задачей данного проекта было попыткой обучить модель Stable Diffusion дать новую жизнь этой эстетике.

Для обучения и генерации изображений использовались портал hugging face и заранее собранный пользовательский датасет.

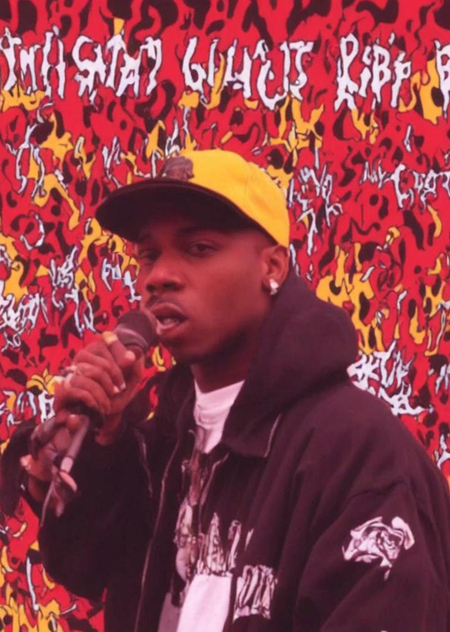

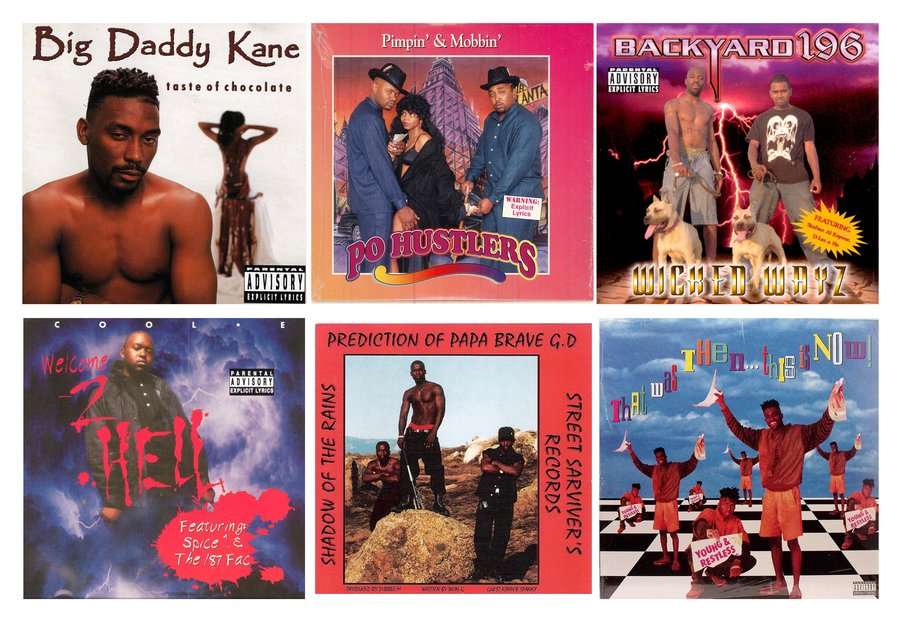

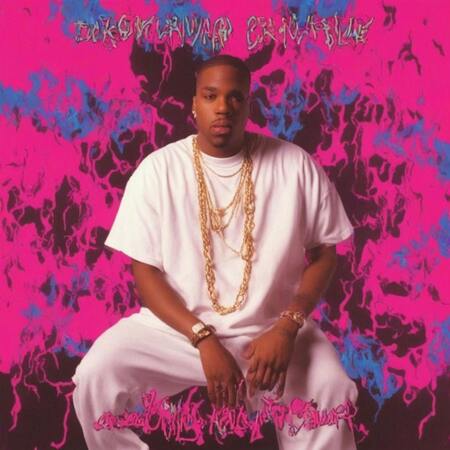

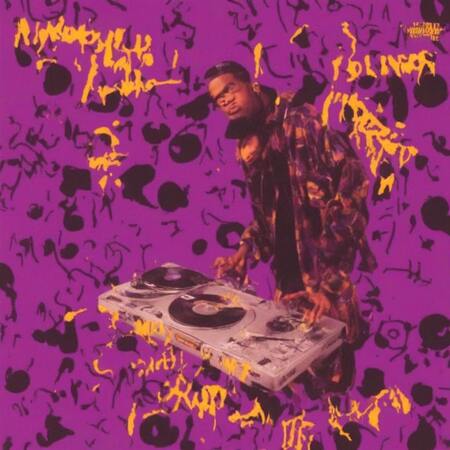

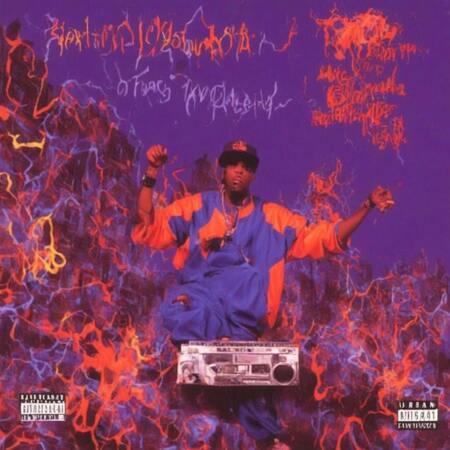

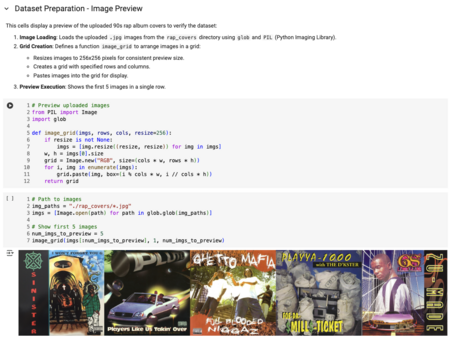

Подготовленный датасет:

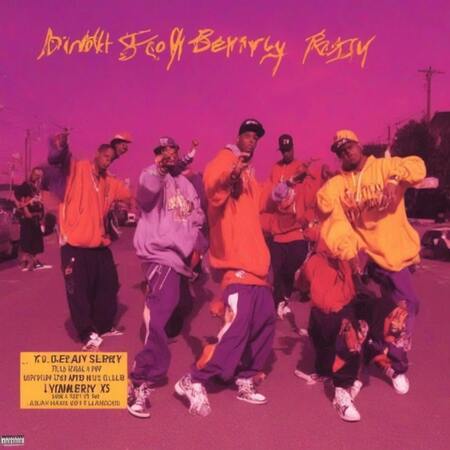

Часть подготовленного датасета

Датасет состоял из 133 изображений — по несколько обложек на каждый год с 1989-го по 2000-й.

Визуальный язык оказался слишком неоднородным и богатым на разнообразие сюжетов, чтобы за ограниченное время научить модель создавать нечто подобное по оригинальности.

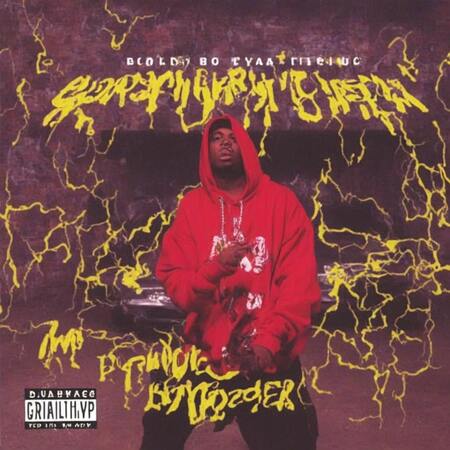

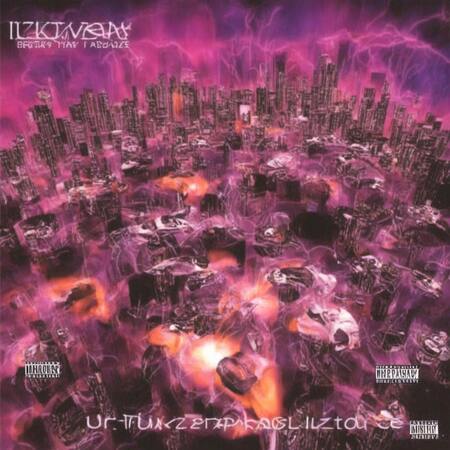

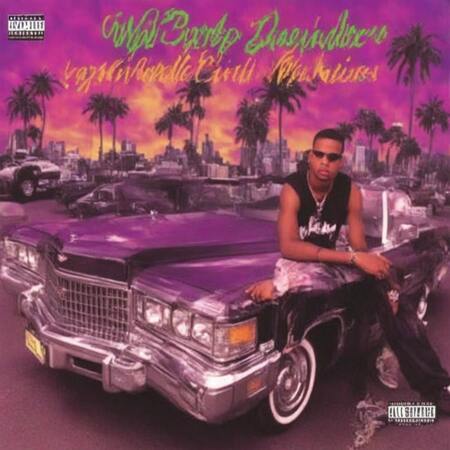

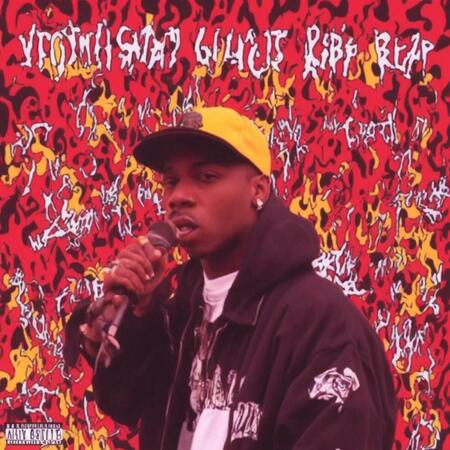

Однако она всё же создала забавные примеры:

Генеративную модель удалось обучить ключевым характеристикам эстетики: контрастные, насыщенные цвета; она уловила характерные выражения лиц и позы в кадре.

Но можно видеть, что на данном этапе модель понимает свою задачу достаточно поверхностно.

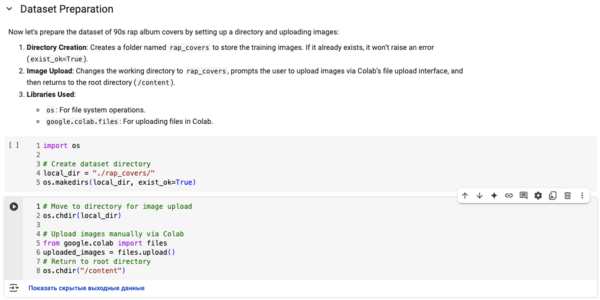

Работа с кодом:

Установка зависимостей

Подготовка датасета

Далее представлено обучение в хронологическом порядке

Промты:

Модель, использованная для до-обучения: https://huggingface.co/stabilityai/stable-diffusion-xl-base-1.0

Энкодер модели: https://huggingface.co/madebyollin/sdxl-vae-fp16-fix