Генерация Покровских в собственном стиле с помощью нейросетей

1. Концепция

Я решила создать сгенерированные нейросетью работы в стиле, в котором рисую я, поскольку, без лишней скромности скажу, являюсь любимым для себя художником.

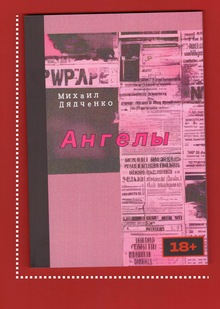

Поскольку я собираюсь в конце модуля презентовать идеи для диплома, мною было принято решение расширить имеющийся арсенал иллюстраций по ориджиналу, который вскоре может стать моей финальной учебной работой.

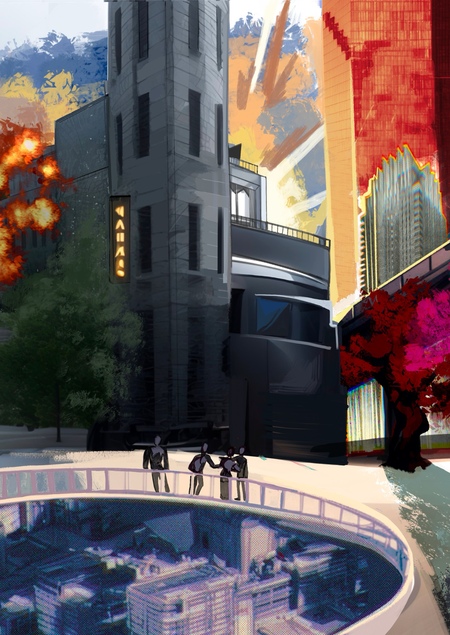

Итоговый проект с вариатива.

В прошлом модуле я попала на вариатив, связанный с разработкой личных вселенных, и я тоже взяла в качестве основной темы оригинальную вселенную: за семь лет я собрала по ней столько материала, что перед защитой тем дипломов мне нужно кардинально подготовиться и наконец воплотить мысли и идеи во что-то существенное.

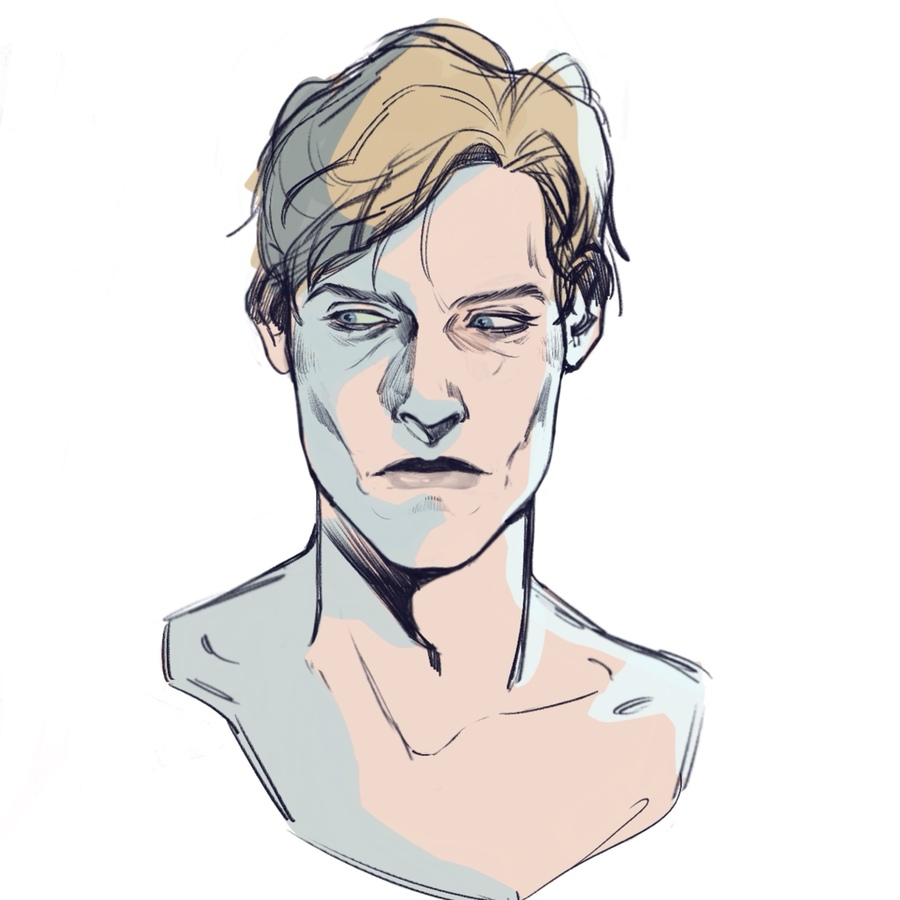

Примеры для обучения, мои личные работы.

Главными объектами исследования стали главный персонаж истории и его родители: Константин, Милана и Алексей Покровские.

2. Серия изображений

3. Анализ результатов

Первое, что хочется сказать — вау. На мой взгляд, нейросеть уловила основные особенности моего стиля: любовь к ярко-выраженным скулам, способ рисования теней, оттенок кожи, румянец и даже лёгкие кожные особенности в виде родинок.

Единственное, глаза для нейросети всё еще самый сложный элемент портрета.

Меня удивило, что способ рисовать волосы абсолютно совпадает с моим собственным: вплоть до цвета лайна, которым я пользуюсь.

Важно отметить, что у меня есть чёткое представлении только о Константине (его внешность его в примерах), но остальные персонажи были только образами в голове, в которые, неожиданно, попал ИИ.

Нейросеть заметила даже одну примечательную особенность: как это бывает у многих художников, любящих создавать портреты, большое количество внимания уделяется лицу, но одежда остаётся чуть менее проработанной. Так вышло и на генерируемых изображениях.

Ну и напоследок добавлю: говоря о фоне, то на моих примерах не было проработанного фона (практически), его не было и на итоговых картинках.

4. Код: процесс создания

*Кроме исходного кода из курса, никаких более ГенИИ не было использовано.

Сначала были импортированы все необходимые библиотеки и материалы. Обучение модели проводилось с использованием методов LoRA и Dreambooth. LoRA позволяет эффективно адаптировать модель, снижая затраты ресурсов, а Dreambooth помогает создавать изображения на основе текстовых описаний.

Затем надо было обрезать фотографии, чтобы они были формата 1:1. У меня было 7 иллюстраций по выбранной мной теме, которые подходили для обучения (на мой взгляд, это не помешало создавать качественные изображения).

Вот так выглядел код:

Далее необходимо было имплементировать и настроить нейросеть BLIP, которая способна делать выводы о происходящем на изображении. Здесь BLIP распознала объекты на изображениях из архива.

Процесс дообучения модели Stable Diffusion XL проходил с использованием собранных данных. Для активации стиля определённой художницы было выбрано триггерное слово «KMPLZ», которое помогает модели генерировать изображения в этом стиле, когда оно встречается в запросе.

Я установила 1000 шагов для обучения и сохраняла результаты каждые 250 шагов, в итоге получив четыре варианта модели для сравнения. Весь процесс занял около часа.

Полученную модель я загрузила на HuggingFace, создав новый токен по лекции курса.

Затем я пробовала запускать и генерировать изображения с помощью полученной модели через Google Colab.

Мой обычный промпт выглядел так:

«art in MY OWN STYLE style, portrait of a blonde men in a suit black background»

Итоговые выводы:

К сожалению, у меня не получилось всё просто повторить за лектором в курсе и создать работу без сильных промахов: например, я долго не могла понять, почему мои картинки не скачиваются компьютером (оказывается, у меня было написано JPG, а не jpg), нужно было добавлять «/content/», экспериментировать с формой написания тех или иных строк, потому что упорно код не хотел работать.

Однако, к счастью, случилось чудо и вся работа наконец-то задышала и сгенерировала мне столько поражающих изображений.